| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- 2023 현대차·기아 CTO AI 경진대회

- ODQA

- Attention

- dataset

- KLUE

- RNN

- pyTorch

- seaborn

- word2vec

- matplotlib

- Self-attention

- Ai

- 데이터 구축

- mrc

- 딥러닝

- passage retrieval

- Bart

- 데이터 시각화

- N21

- 기아

- AI Math

- Data Viz

- N2N

- 현대자동차

- AI 경진대회

- Bert

- Transformer

- Optimization

- GPT

- nlp

- Today

- Total

쉬엄쉬엄블로그

(딥러닝) Neural Networks & Multi Layer Perceptron 본문

이 색깔은 주석이라 무시하셔도 됩니다.

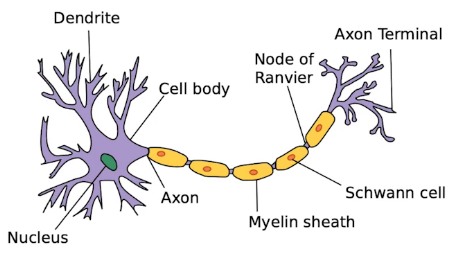

Neural Networks

"Neural networks are computing systems vaguely inspired by the biological neural networks that constitute animal brains." - wikipedia

- Neural networks은 동물 두뇌의 생물학적 신경망을 통해 애매한 영감을 받은 연산 체계이다.

- 시작은 인간의 뇌를 모방하고 뉴런의 동작 방법을 모방하는 것으로 시작했지만 지금의 딥러닝 연구 트렌드는 인간의 뇌를 모방해서 잘 된다고 말하기에는 많이 달라졌다.

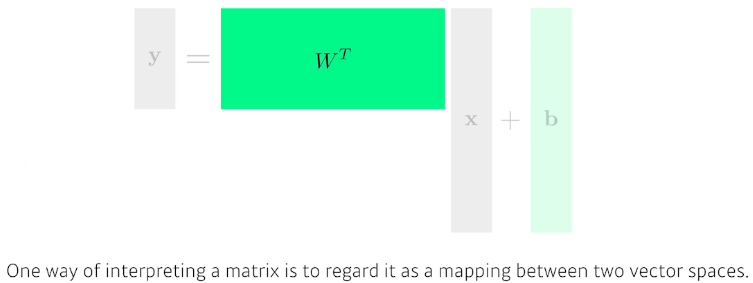

Neural networks are function approximators that stack affine transformations followed by nonlinear transformations.

- 뉴럴 네트워크는 비선형 변환과 아핀 변환이 반복적으로 이루어져있는 근사 함수

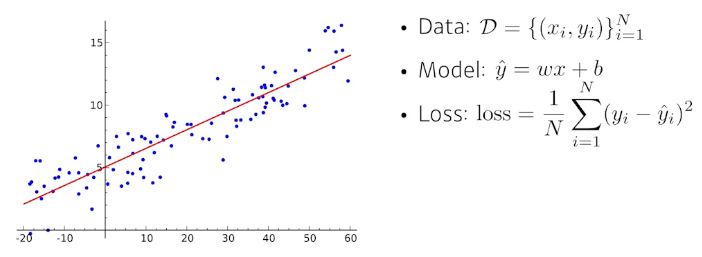

Linear Neural Networks

Let's start with the most simple example.

- 가장 간단한 예제부터 확인해보자

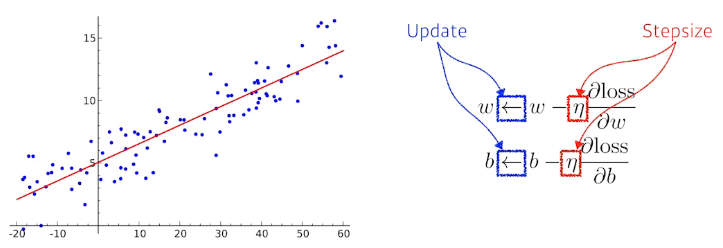

We compute the partial derivatives with respect to the optimization variables.

- 최적화 변수에 대해 편미분 계산

Then, we iteratively update the optimization variables.

그 후, 최적화 변수를 반복적으로 갱신

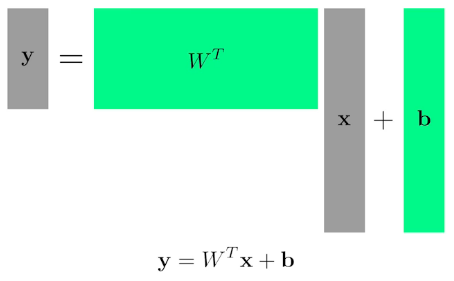

of course, we can handle multi dimensional input and ouptut.

다차원 입력과 출력도 처리할 수 있음

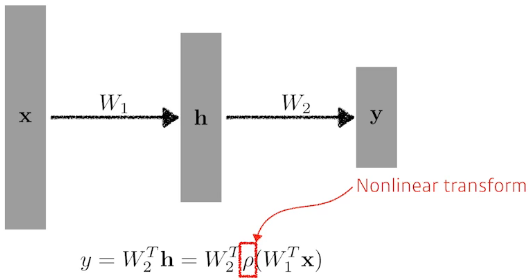

Beyond Linear Neural Networks

What if we stack more?

Linear Neural Networks를 더 쌓는다면 어떨까?

We need nonlienarity.

Linear Neural Networks를 더 쌓아서 모델이 좋은 성능을 보이려면 비선형성이 필요함

선형 결합 후에 activation function을 곱해서 nonlinear transform을 거치도록 하여 오차가 줄어들도록 변수들을 갱신시킴

Activation functions

- 뉴럴 네트워크의 표현력이 굉장히 크지만 이걸 어떻게 찾는지는 잘 모름

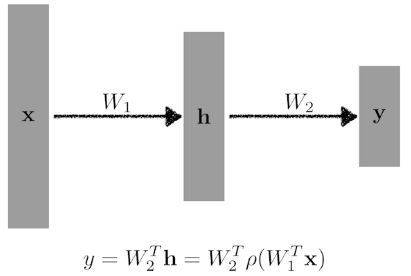

Multi-Layer Perceptron

This class of architectures are often called multi-layer perceptrons.

- 이러한 구조를 다층 퍼셉트론 구조라고 부름

Of course, it can go deeper.

- 더 깊게 쌓을 수도 있음

What about the loss functions?

- 어떤 loss function이 있을까?

선형 결합을 n번 반복하는 것이 아니라 선형 결합 후에 activation function을 곱해서(이용해서) nonlinear transform을 거치는 것을 반복하여 얻어지는 feature vector가 많은 표현력을 갖게 됨

출처: 부스트캠프 AI Tech 4기(NAVER Connect Foundation)

'부스트캠프 AI Tech 4기' 카테고리의 다른 글

| (딥러닝) Convolutional Neural Networks (1) | 2023.05.30 |

|---|---|

| (딥러닝) Optimization (0) | 2023.05.29 |

| (딥러닝) Historical Review (0) | 2023.05.27 |

| Transfer Learning + Hyper Parameter Tuning (0) | 2023.05.26 |

| Custom Dataset 및 Custom DataLoader 생성 (0) | 2023.05.25 |