부스트캠프 AI Tech 4기

(NLP 기초대회) Huggingface

쉬엄쉬엄블로그

2023. 7. 20. 14:19

728x90

이 색깔은 주석이라 무시하셔도 됩니다.

Hugginface 소개

Hugginface

Transfer Learning

- 수학 문제를 잘 푸는 친구에게 경제 문제를 잘 풀도록 접근하는 것

- 비슷한 분야를 학습해놓은 모델에게 유사한 다른 문제들을 잘 풀도록 학습시키는 것

Transfer Learning | Pretraining & Fine-tuning pattern

- large-scale raw data로 학습시킨 후 small-scale tagged data로 전이학습 시켰을 때 SOTA 성능을 보임

Transfer Learning | Pre-training

- 대규모 말뭉치들을 활용해 (상대적으로 쉬운) 언어 문제들을 해결할 수 있는 언어모델 구축 및 배포

- 계속 더 좋은 모델 및 더 큰 모델이 배포되고 있음

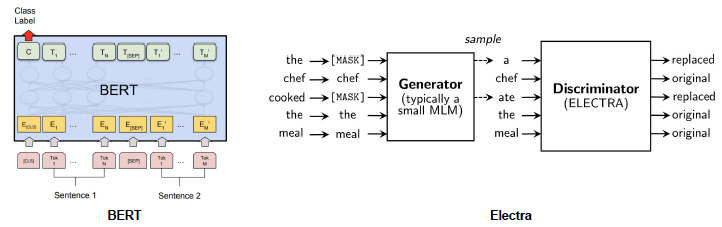

- 인코더 Block만 활용해서 만든 것이 BERT

Transfer Learning | Fine-tuning

- Pre-training된 모델을 연구 및 상용화에 맞게 특정 문제(dataset)에 대해 추가 학습

Why Huggingface?

- NLP의 학습 과정

- Huggingface에 대해 배우기 이전에, 자연어 처리의 학습 과정을 다시 한번 되짚어 보기

- ML 기반 자연어 처리 모듈은 크게 3가지 자원이 필요하다.

- Model(현재 대부분은 Transformer) Parameter

- 어휘 사전 (Token, embedding value)

- Tokenization 방법 (코드)

- 허깅페이스가 사용자들이 바닥부터 고생하지 않게끔 도와줌

- HuggingFace의 모델들

https://huggingface.co/models - 만든 모델을 HuggingFace에 업로드하면 좋은 논문이나 연구의 결과를 많은 사용자들이 쉽게 사용할 수 있음

What is Huggingface

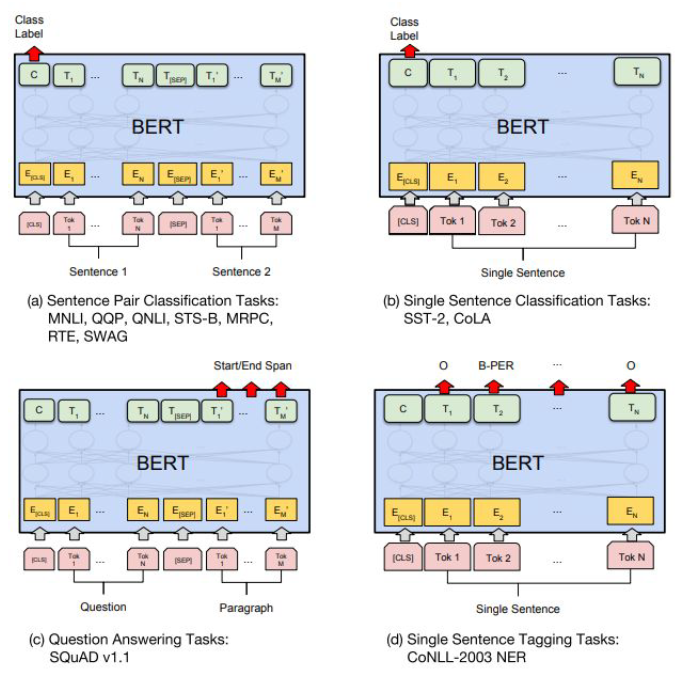

- 다양한 task의 Pre-trained model들을 제공

How do we use it?

기 배포된 모델/자원을 쉽게 활용 가능

자주 반복되는 Utility (예 - 문장생성) 등이 제공됨

https://huggingface.co/docs/transformers/v4.20.1/en/main_classes/text_generation

출처: 부스트캠프 AI Tech 4기(NAVER Connect Foundation)